扩散语言模型推理太慢?北大团队提出ODB-dLLM框架,破解计算访存双重瓶颈

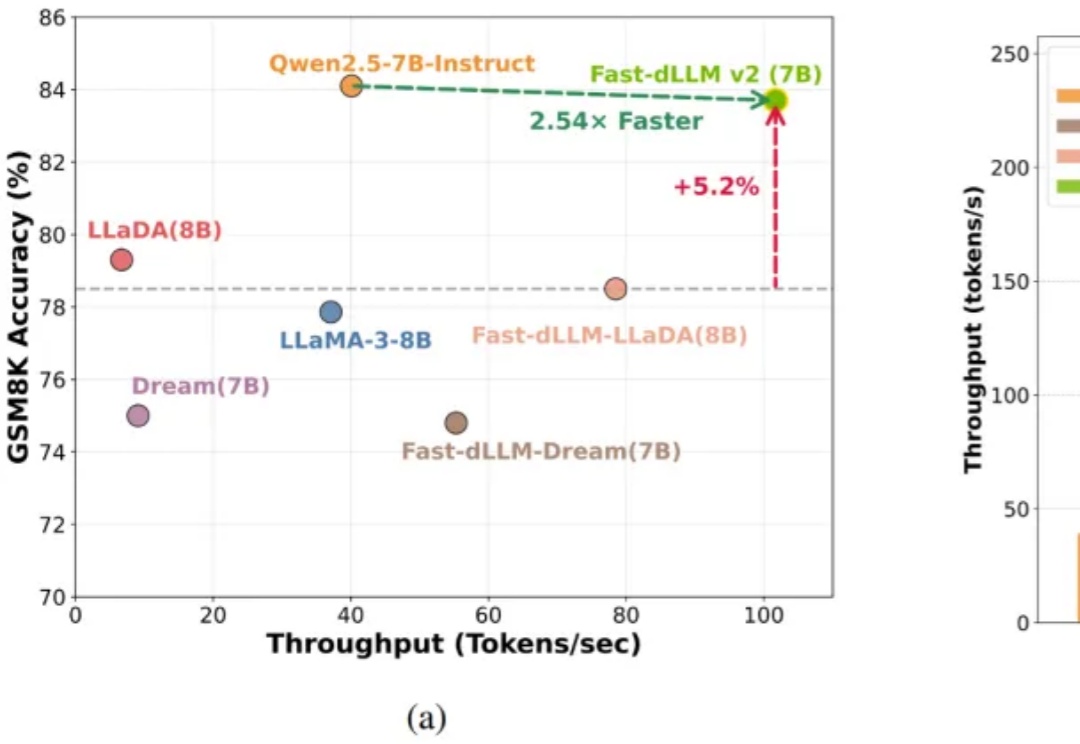

扩散语言模型推理太慢?北大团队提出ODB-dLLM框架,破解计算访存双重瓶颈基于扩散的大语言模型 (dLLM) 凭借全局解码和双向注意力机制解锁了原生的并行解码和受控生成的潜力,最近吸引了广泛的关注。例如 Fast-dLLM 的现有推理框架通过分块半自回归解码进一步实现了 dLLM 对 KV cache 的支持,挑战了传统自回归 LLMs 的统治地位。

来自主题: AI技术研报

5536 点击 2025-12-11 10:42